Meta 發表了開放原始碼模型 Llama 3,包括預先訓練和指令調整的模型,參數為 8B 和 70B,以及新版的 AI 助理。

完整版的 Llama3 預計將於今年七月上市,並具備多模態功能。Meta 已將新的電腦編碼功能嵌入 Llama3,可輸出文字和圖像,並計畫應用在雷朋 Meta 智慧眼鏡上。Meta 已與 Google 合作,在 AI 助理的回應中加入即時搜尋結果。

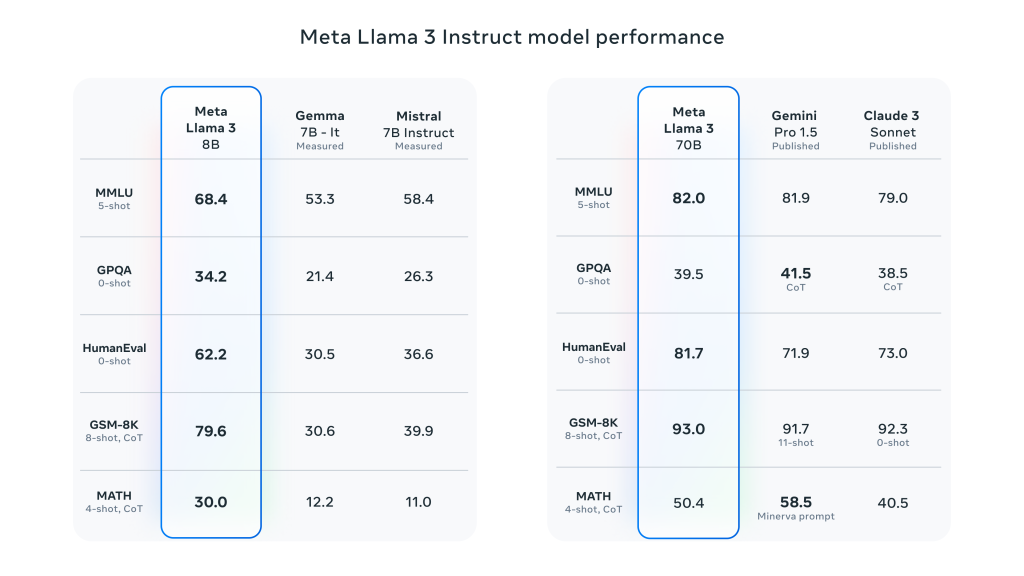

Llama 3 在 Llama 2 的基礎上有了重大的躍進,並在廣泛的業界基準上展現出 SOTA 的效能。除了改進推理、代碼生成和指令追蹤之外,這些模型還顯著降低了錯誤拒絕率,改進了對齊性,並增加了模型回應的多樣性。Meta 為此建立了兩個 24,000 個 GPU 叢集,並讓 Llama 3 模型同時在其中 16,000 個 GPU 上進行訓練!

Meta 宣稱 Llama 3 8B 和 70B 機型只是 Llama 3 正式發行的開始。的 他們目前正在研究的最大機型是 400B+ 參數儘管他們仍在積極開發中,但他們對於這項工作的發展方向感到非常興奮。

Meta Llama 3 的詳細關鍵性能特性:

- 機型尺寸與類型:

- 參數大小:Meta Llama 3 提供 8B (80 億) 和 70B (700 億) 兩種尺寸的模型。

- 型號類型這些模型是經過預先訓練和教學調整的生成文字模型,已針對會話和其他語言處理任務進行最佳化。

- 模型架構:

- 自回歸語言模型:Llama 3 以最佳化的 Transformer 架構為基礎,使用自回歸方法產生文字。

- 群組查詢注意力 (GQA):模型中使用了 Grouped-Query Attention 機制,以提高大規模參數下的推理可擴展性。

- 訓練與資料處理:

- 訓練資料量:Llama 3 使用超過 15 兆 代幣 進行預訓,訓練集比 Llama 2 大七倍,包括四倍的程式碼量。

- 微調:透過監督微調 (SFT) 和包含人類回饋的強化學習 (RLHF) 來調整模型指令,以更符合人類對有用性和安全性的偏好。

- 預訓資料集有 5% 非英語資料集,共有 高達 30 支援 語言

- 績效與基準:

- 整體績效改善:Llama 3 在對話、問答和推理等多種任務的多個自動化基準中表現良好。

- 基準比較:與之前的模型 (例如 Llama 2) 相比,Llama 3 在多項任務上都有顯著的效能提升。

發佈留言